Suara.com - Sebuah sistem kecerdasan buatan (artificial intelligence atau AI) yang ditanam dalam sebuah robot berhasil mengalahkan seorang juara Eropa dalam permainan Go, permainan kuno asal Cina yang juga disebut sebagai salah satu permainan tradisional paling rumit di dunia.

AlphaGo, nama sistem ciptaan Google DeepMind dari London, Inggris itu , berhasil mengalahkan Fan Hui, yang pernah tiga kali menjuarai turnamen Go Eropa. Tak main-main, otak robotik itu mengalahkan Hui dengan skor 5-0.

Para ilmuwan menuangkan hasil pengamatan dan analisis terhadap kemampuan AI dalam mengalahkan juara dunia Go itu dalam jurnal Nature edisi 27 Januari kemarin.

Tanguy Chouard, editor Nature, menggambarkan prestasi ini sebagai "tonggak sejarah" dalam pengembangan AI, yang menyasar "tepat pada inti dari misteri kecerdasan".

Permainan komputer sejak lama dipercaya oleh sains sebagai tempat menguji AI, untuk menemukan algorima cerdas dan fleksibel, yang bisa mengatasi masalah-masalah alam keseharian manusia.

Para ilmuwan mengatakan keberhasilan AlphaGo merupakan pertanda bahwa AI kini telah semakin canggih dan strategi belajarnya bisa menjadi alat yang sangat kuat di arena lain, seperti untuk mempelajari data-data iklim yang tidak memiliki pola atau juga dalam membuat diagnosis yang rumit dalam dunia kedokteran. Selain itu, AI bisa membuat teknologi telepon seluler pintar semakin cerdas.

Tantangan AlphaGo berikutnya akan digelar pada Maret di Seoul, Koreal Selatan. Robot itu akan berduel melawan Lee Sedol, juara Go dunia, yang belum terkalahkan dalam 10 tahun terakhir.

"Saya sudah mendengar bahwa sistem AI milik Google DeepMind sangat kuat, tetapi saya yakin bahwa saya bisa menang nanti," kaa Sedol dalam pernyataan resminya.

Selanjutnya: Mengalahkan Konfigurasi Atom

Mengalahkan Konfigurasi Atom

Sejak sistem Deep Blue ciptaan IBM mengalahkan grand master catur Gary Kasparov dalam laga bersejarah mereka pada 1997, para ilmuwan AI diam-diam terus mendesain robot yang bisa lebih cerdas dari manusia.

Pada 2014 lalu sistem Watson dari IBM berhasil mengalahkan Ken Jennings dalam permainan Jeopardy!. Pada 2015 kemarin sebuah komputer bernama Claudio berhasil menguras uang para penjudi kartu poker di sebuah kasino di Pittsburgh, Amerika Serikat.

Tetapi berbeda dari catur, Jeopardy!, atau poker, permainan Go adalah yang paling sukar dipelajari. Ini adalah permainan strategi yang diciptakan di Cina sekitar 2.500 tahun lalu. Permainan ini memiliki aturan sederhana, tetapi yang juga bisa membuat terlena.

Dalam permainan itu dua pemain menggunakan bidak-bidak berwarna putih dan hitam, mirip catur. Bedanya, dalam permainan ini tujuannya adalah untuk menguasai wilayah paling besar atau lebih dari 50 persen permukaan papan yang dibagi dalam kotak-kotak kecil.

Aturannya sederhana. Bidak-bidak putih, misalnya, harus terus saling berhubungan dalam sebuah garis agar tetap hidup. Jika terpisah atau berhasil dipisahkan oleh bidak hitam milik lawan, maka bidak itu mati.

Tetapi di balik aturan sederhana ini, terletak kerumitan luar biasa. Master dalam permainan ini bisa menghabiskan hidupnya untuk mempelajari rangkaian langkah, merancang strategi, mengembangkan kemampuan untuk menganalisis papan go, dan bisa mengetahui dengan cepat bidak mana yang masih hidup, mati, atau sudah "sekarat".

"Ini mungkin permainan yang paling rumit yang pernah diciptakan oleh manusia," kata Demis Hassabis, pakar ilmu komputer dari Google DeepMind.

Ia mengatakan bahwa Go memiliki konfigurasi yang lebih banyak ketimbang atom-atom dalam alam semesta.

Selanjutnya: Mesin Berinsting

Mesin Berinsting

Menghadapi kerumitan itu, jelas Hassabis, timnya lalu merancang AlphaGo untuk bisa beroperasi berdasarkan "intuisi dan perasaan".

"Dalam permainan Go, kami butuh mesin yang sangat rumit dan berinsting, kemampuan yang tadinya dikira hanya dimiliki oleh otak manusia, mesin yang memiliki pikiran tentang siapa yang sedang unggul dan langkah apa yang harus diambil," jelas David Silver, pakar komputer pada Google DeepMind, yang ikut mengembangkan AlphaGo.

AlphaGo pada dasarnya hanya "menonton" jutaan pertandingan Go antara manusia untuk mempelajari aturan dan strategi dasar permainan kuno. Sistem itu kemudian berlatih melawan dirinya sendiri untuk menciptakan strategi-strategi baru.

Dalam proses belajar itu AlphaGo menggunakan pendekatan yang disebut "deep learning" atau "deep neural networks" - jaringan yang memiliki jutaan koneksi mirip syaraf. Dalam jaringan ini analisis dan hitungan dilakukan pada beberapa lapis hierarki yang tersusun secara terorganisasi. Data akan dianalisis dari lapisan paling rendah hingga paling tinggi.

Ada dua perangkat jaringan dalam AlphaGo. Pertama adalah jaringan nilai (value network), yang bertugas melihat posisi bidak pada papan Go dan memutuskan siapa yang akan menang dan mengapa ia menang. Kedua adalah jaringan kebijakan (policy network), yang memutuskan langkah apa yang akan diambil.

Seiring waktu, jejaring kebijakan akan melatih jejaring nilai agar bisa melihat bagaimana sebuah permainan berjalan.

Tidak seperti metode-metode AI sebelumnya, yang berusaha mengkalkulasi keuntungan dari setiap langkah menggunakan brute force (dari proses trial and error berulang-ulang kali), program ini hanya akan memilih langkah yang menurutnya memberikan peluang menang paling besar - metode yang lazim digunakan oleh manusia.

"Sistem ini mencari (langkah) dengan memainkan permainan ini berulang-ulang kali dalam imajinasinya sendiri. Ini yang membuat pencarian AlphaGo lebih mirip manusia ketimbang mesin-mesin sebelumnya," jelas Silver.

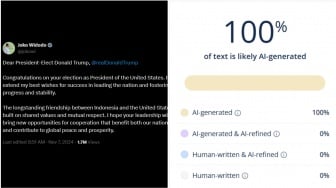

Dalam proses pengembangannya AlphaGo terus dilatih dengan bermain menghadapi program-program komputer Go lainnya. Ia memenangkan 499 dari 500 laga yang digelar. Pada Oktober 2015 lalu, ia mengalahkan Hui. (Phys.org/Live Science)